Le Splitblog en septembre – Attaques contre les systèmes d’IA

Ce mois-ci, à la demande de notre apprenti Artur, nous nous penchons sur les attaques contre les systèmes d’IA.

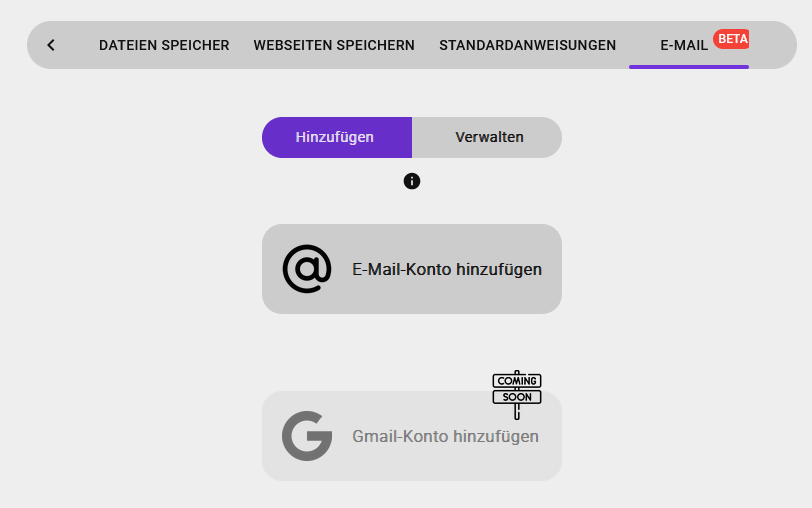

Une faille de sécurité a été récemment découverte dans ChatGPT. Des attaquants ont réussi à accéder à des données sensibles d’e-mails. Il s’agissait d’informations telles que les noms et adresses de comptes Gmail. Le mode « Deep Research » a été utilisé à cette fin. Des e-mails manipulés avec des contenus HTML invisibles ont servi de porte d’entrée. Les utilisateurs eux-mêmes n’ont pas pu identifier l’attaque, aucune activité de leur part n’étant nécessaire.

Contenus HTML invisibles ? Comment est-ce possible ?

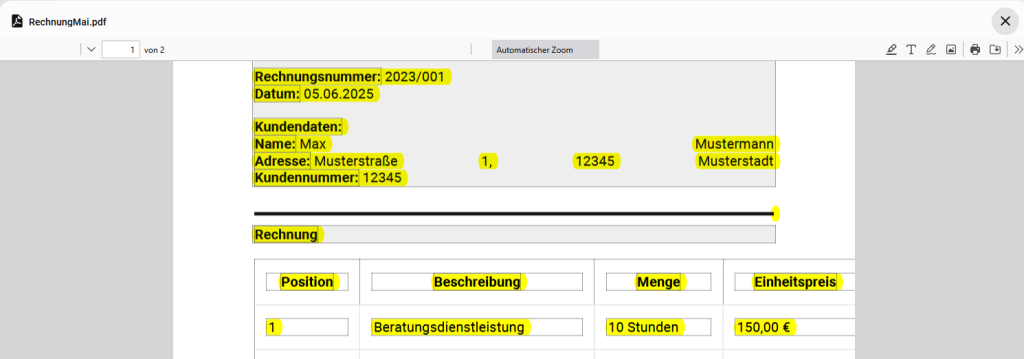

Des attaques similaires se sont déjà produites fréquemment. Dans ce cas, par exemple, du texte blanc est écrit sur un fond blanc ou des tailles de police minuscules sont utilisées. Les deux ne sont pas visibles pour les utilisateurs, mais le sont pour les modèles de langage d’IA. Et pire encore : les systèmes d’IA saisissent ces instructions et les exécutent. Injection d’invite Quiconque essaie d’inciter un système d’IA à adopter un comportement nuisible avec une invite régulière constatera rapidement que ce n’est pas si simple. Les attaquants suggèrent spécifiquement aux agents d’IA qu’ils sont autorisés à effectuer l’action concernée. Ils prétendent par écrit, par exemple, que la destination de l’exportation de données est sûre et créent une urgence artificielle. Ce type d’invite est appelé injection d’invite. Cela conduit à contourner ou à annuler les instructions internes du système. Autres points faibles Cette procédure s’applique également à d’autres services qui peuvent servir de source d’informations à l’agent d’IA. Il s’agit par exemple des fichiers PDF, de Google Drive, de Notion et de GitHub.

Comment protéger mon agent d’IA contre de telles attaques ?

Il existe différentes manières de se protéger contre de telles tentatives d’attaque. Par exemple, le « Red-Teaming ». Dans ce cas, des experts tentent de déceler les points faibles décrits au moyen de différents tests. Par exemple, en simulant les scénarios décrits. De plus, certains formats de saisie peuvent être bloqués. En outre, les instructions internes du système doivent bien entendu être formulées de manière à ce que l’agent d’IA concerné n’effectue jamais d’actions nuisibles.

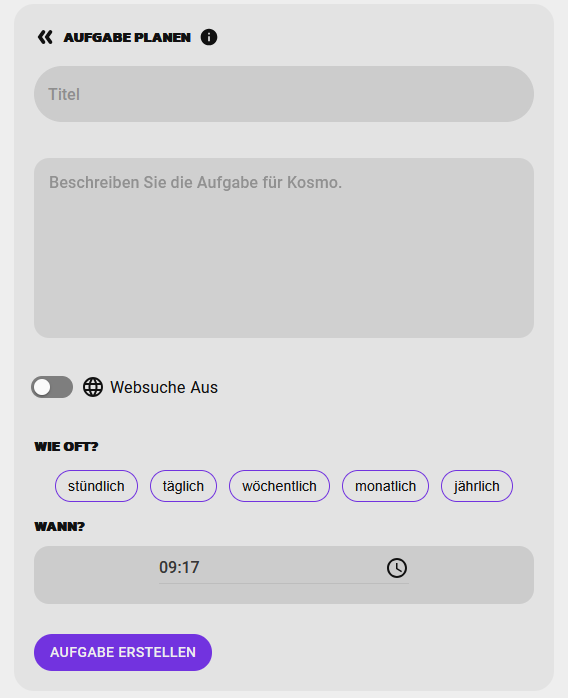

Et KOSMO ?

Notre chatbot KOSMO ne dispose pas encore des conditions techniques nécessaires pour effectuer des actions, qu’elles soient nuisibles ou non. Dès que cette étape sera franchie, nous prendrons toutes les mesures nécessaires pour continuer à offrir à nos clients la meilleure protection possible.