Splitblog we wrześniu – Ataki na systemy AI

W tym miesiącu, na prośbę naszego stażysty Artura, zajmujemy się atakami na systemy AI.

Niedawno ujawniono lukę bezpieczeństwa w ChatGPT. Napastnikom udało się uzyskać dostęp do wrażliwych danych e-mail. Dotyczyło to informacji takich jak imiona, nazwiska i adresy z kont Gmail. Wykorzystano do tego tryb „Deep Research”. Jako bramę wejściową posłużyły zmanipulowane wiadomości e-mail z niewidoczną zawartością HTML. Sami użytkownicy nie byli w stanie wykryć ataku, a ich aktywność nie była wymagana.

Niewidoczna zawartość HTML? Jak to możliwe?

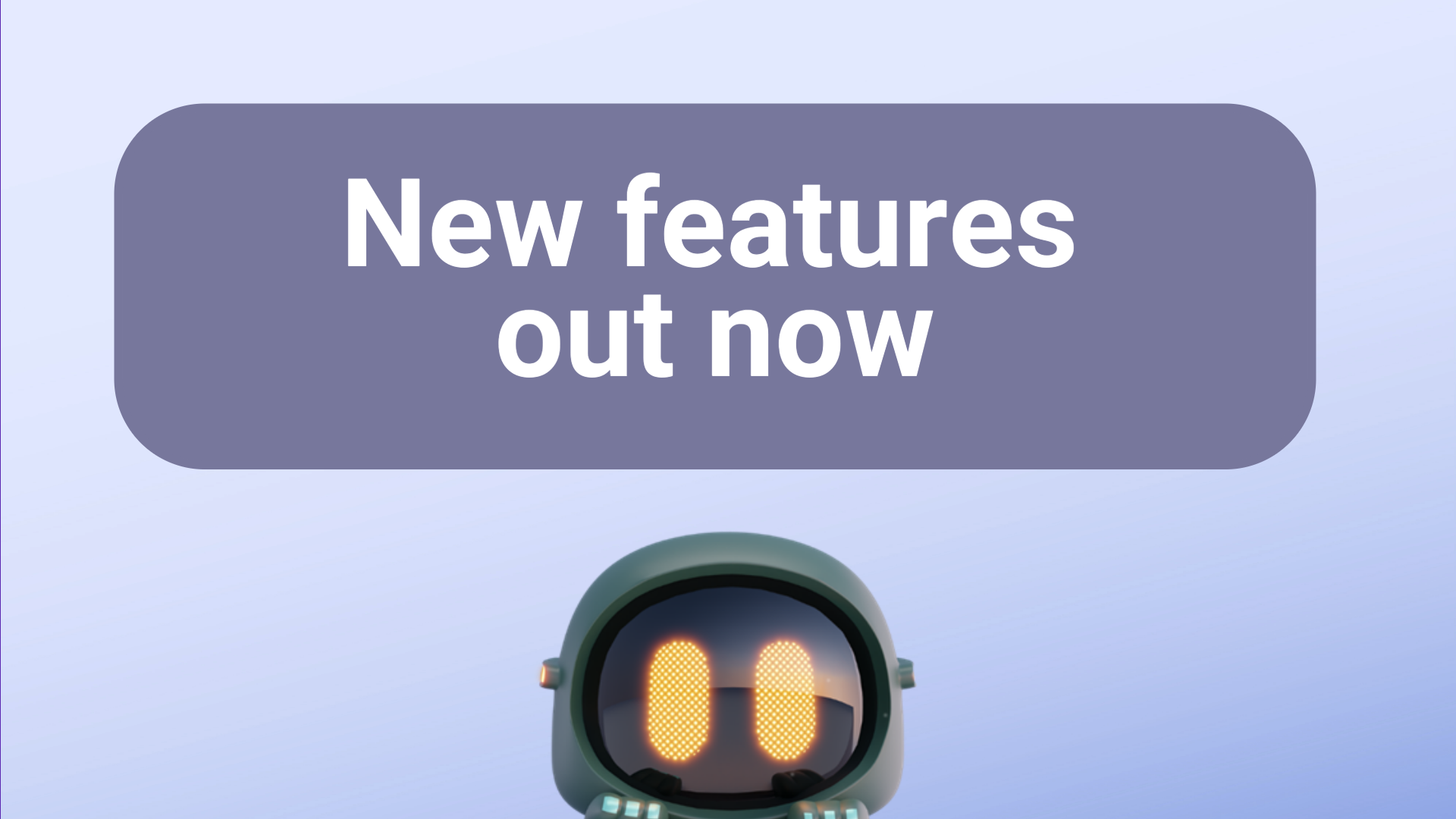

Ataki w podobnej formie zdarzały się już wcześniej. W tym przypadku na przykład biały tekst jest pisany na białym tle lub używane są bardzo małe rozmiary czcionek. Oba te elementy są niewidoczne dla użytkowników, ale widoczne dla modeli językowych AI. Co gorsza: systemy AI rejestrują te instrukcje i je wykonują. Wstrzykiwanie promptów (Prompt-Injection) Kto próbuje skłonić system AI do szkodliwego zachowania za pomocą zwykłego promptu, szybko zauważy, że nie jest to takie proste. Napastnicy celowo sugerują agentom AI, że są upoważnieni do danego działania. Tekstowo udają, że np. cel eksportu danych jest bezpieczny i tworzą sztuczne poczucie pilności. Ten rodzaj promptowania nazywa się wstrzykiwaniem promptów (Prompt-Injection). Prowadzi to do ominięcia lub unieważnienia wewnętrznych instrukcji systemowych. Inne słabe punkty To podejście dotyczy również innych usług, które mogą służyć agentom AI jako źródło informacji. Należą do nich na przykład pliki PDF, Google Drive, Notion i GitHub.

Jak chronić mojego agenta AI przed takimi atakami?

Istnieją różne sposoby ochrony przed takimi próbami ataku. Na przykład tak zwany Red-Teaming. W tym przypadku eksperci próbują zidentyfikować opisane słabe punkty za pomocą różnych testów. Na przykład poprzez symulowanie opisanych scenariuszy. Ponadto można blokować określone formaty wejściowe. Ponadto, oczywiście, wewnętrzne instrukcje systemowe powinny być sformułowane w taki sposób, aby dany agent AI nigdy nie wykonywał szkodliwych działań.

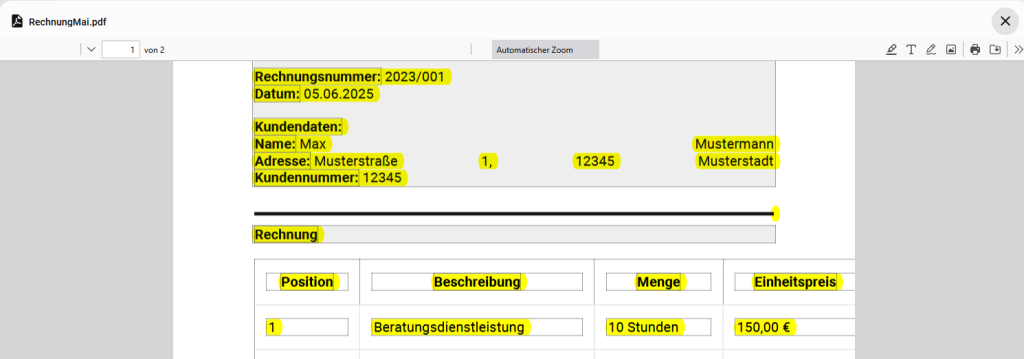

A KOSMO?

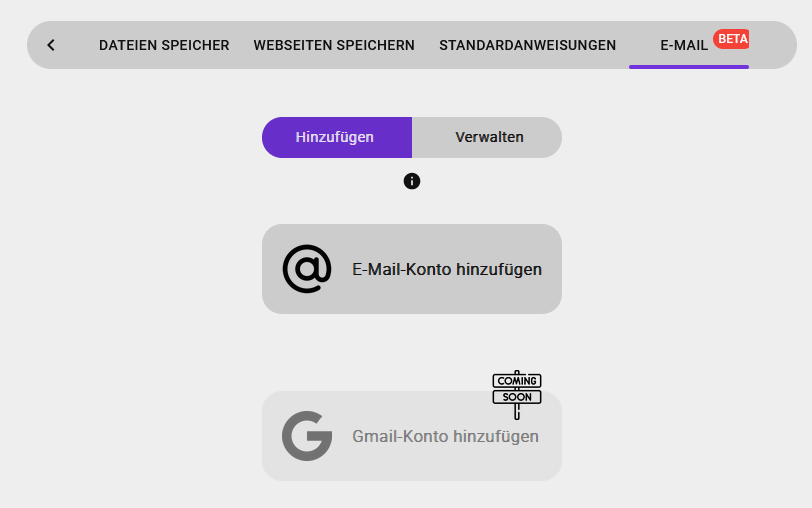

Nasz chatbot KOSMO nie posiada obecnie technicznych możliwości wykonywania działań – ani szkodliwych, ani nieszkodliwych. Gdy tylko nadejdzie ten etap, podejmiemy wszelkie środki, aby nadal oferować naszym klientom najlepszą możliwą ochronę.